O Dia que sai da Matrix sem querer

Quando uma mensagem de erro mostra a verdade sobre a Internet, uma verdade que você não quer ver

Quando o algoritmo decide antes de você publicar: reflexões sobre filtros, políticas e censura prévia nas redes sociais

Recentemente, ao tentar publicar um vídeo no Instagram pelo navegador, me deparei com algo curioso: o conteúdo foi enviado normalmente, mas a publicação falhou no momento final — sem aviso claro ao usuário, apenas uma mensagem genérica de erro. O detalhe é que, em vez de uma explicação simples, o sistema expôs um stack trace técnico interno do próprio backend da plataforma.

Para quem não é da área, isso pode parecer apenas um bug. Para quem trabalha com tecnologia, arquitetura de sistemas e governança digital, isso levanta uma reflexão bem mais profunda e extremamente preocupante.

O conteúdo chegou. O problema não foi técnico.

O vídeo estava dentro de todos os padrões técnicos exigidos pela plataforma. Não se tratava de formato, codec, tamanho ou qualquer limitação de mídia. O erro ocorreu depois do upload, no momento da efetiva publicação.

Ou seja: o conteúdo entrou no sistema, foi processado, avaliado… e não foi publicado.

Isso muda completamente a natureza da discussão.

O que o erro técnico revelou (sem querer)

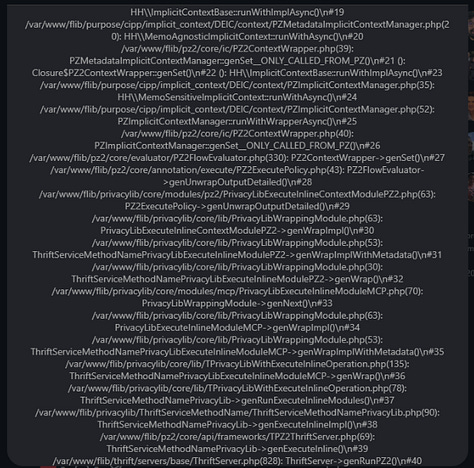

O stack trace exposto pelo sistema mostra que a publicação passa por um pipeline interno complexo, envolvendo:

Contexto do usuário (sessão, tipo de conta, flags internas)

Camadas chamadas internamente de Policy Zone (PZ / PZ2)

Avaliação de fluxo de decisão (Flow Evaluator)

Módulos explícitos de Privacy, Policy e Compliance

Em termos simples: antes de um conteúdo ir ao ar, ele é avaliado por múltiplas camadas de regras internas.

Nada disso é, por si só, errado. Plataformas precisam moderar conteúdo. O ponto sensível está em como isso acontece.

Moderação ou censura prévia algorítmica?

Quando um conteúdo é analisado antes de ser publicado, e pode ser bloqueado:

sem explicação clara, sem feedback específico ao criador, sem transparência sobre o critério aplicado, entramos em um território delicado: o da moderação preventiva automatizada, ou, como muitos já chamam, censura prévia algorítmica.

Não se trataria, necessariamente, de censura intencional ou ideológica. Na maioria dos casos, são políticas automatizadas, modelos de risco, heurísticas e classificadores que decidem se algo “pode ou não” avançar no pipeline.

Porém, o conteúdo que eu publicava falava muito sobre as questões de politica publicas importantes principalmente nas questões tributárias e sobre como funciona como os empreendedores.

O problema é que, para quem cria conteúdo, o efeito prático é o mesmo: o conteúdo simplesmente não aparece. O ponto crítico não é a moderação — é a transparência

Redes sociais têm o direito (e o dever) de moderar conteúdo. Mas quando:

o bloqueio ocorre antes da publicação, o motivo não é informado, não há indicação se foi política, risco, tema ou contexto, cria-se um vácuo de governança.

O criador não sabe: se errou, se foi penalizado, se o tema é sensível ou se está apenas preso em uma regra opaca do sistema.

Um debate que vai além de uma postagem, o que pode ser claramente uma prova de censura prévia no Brasil? Algo que nunca poderia publicar em nenhuma rede, inclusive meu post foi removido em outra rede Brasil.

Será que esse Brasil é livre?